دیگر به تصاویر هم اعتباری نیست!

اگر تا پیش از این از فتوشاپ برای ایجاد تصاویر جعلی استفاده میکردند که هرگز در واقعیت وجود نداشت، اکنون به لطف پیشرفت فناوری، ویدئوهای جعلی هم به گردونه اضافه شدهاند.

ایسنا: اگر تا پیش از این از فتوشاپ برای ایجاد تصاویر جعلی استفاده میکردند که هرگز در واقعیت وجود نداشت، اکنون به لطف پیشرفت فناوری، ویدئوهای جعلی هم به گردونه اضافه شدهاند.

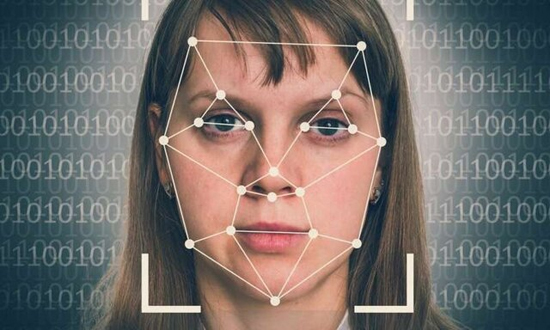

دیپفیک یا جعل عمیق، تکنولوژی خبرساز این روزهاست؛ در حالی که با استفاده از این تکنیک میتوان از ترکیب تصویر انسان و با بهرهگیری از هوش مصنوعی، ویدئوهای ساختگی ایجاد کرد، این فناوری نگرانیهایی را ایجاد کرده است؛ از این جهت که ممکن است با داشتن تصاویر هر شخص، ویدیوهایی از او ساخته شود که واقعیت ندارد و بتواند برای او دردسر ایجاد کند.

دیپفیک تصاویر و فیلمهای موجود را روی تصاویر یا فیلمهای منبع قرار میدهد و میتواند فرد یا افرادی را در حال انجام یک کار در موقعیتی نشان میدهد که هرگز در واقعیت اتفاق نیفتاده است. این فیلمهای تقلبی میتواند فرد را در حال انجام اقدامات نامناسب نشان دهد که هرگز در آن شرکت نکرده است و یا برای تغییر کلمات یا حرکات یک سیاستمدار مورد استفاده قرار گیرد تا به نظر برسد آن فرد چیزی را گفته که هرگز انجام ندادهاست.

به نظر میرسد این تکنولوژی حدود یک سال میشود که قربانیانی گرفته است. از بازیگران خارجی که از تصاویر آنها برای فیلمهای نامناسب سوءاستفاده شده تا سیاستمدارانی که در ویدئوهای دیپ فیک حرفهایی زدند که هرگز در واقعیت بر زبان نیاوردهاند و همین موضوع موجب میشود نتوان نسبت به این تکنولوژی بیتفاوت بود، زیرا افراد نگران تأثیرات این ویدئوها و خصوصاً در بحثهای سیاسی هستند.

وبسایت گاردین دربارهی این موضوع مینویسد: بسیاری از ترسهای ما در مورد تکنولوژی بیش از حد است. به عنوان مثال، علیرغم نگرانی در مورد رسانههای اجتماعی، به طور کلی، تحقیقات نشان میدهد که شواهد کمی درخصوص تأثیر عمده این رسانهها بر سلامت روان افراد وجود دارد. با وجود این، هر تکنولوژی که به سرعت در حال توسعه است، میتواند پیامدهای پیشبینی نشدهای داشته باشد.

ساندرا واچر - پروفسور در زمینهی حقوق و اخلاق هوش مصنوعی - میگوید ارائهی فیلمها یا اطلاعات نادرست و جعلی جدید نیست، اما همه چیز به سرعت تغییر میکند و این باعث میشود توانایی ما در مقابله با چنین موضوعاتی به چالش کشیده بود. روش پیچیدهای که در آن اطلاعات جعلی ایجاد میشود، این جعل اطلاعات چه سرعتی دارد و اینکه تا چه اندازه بیحد و مرز ادامه مییابد، در سطح دیگری قرار دارد. در گذشته میتوانستیم دروغ را گسترش دهیم، اما گسترهی آن محدود بود.

از طرفی با وجود مشکلاتی که دیپفیک میتواند برای افراد ایجاد کند، هنوز قوانین مدونی برای مقابله با آنها وجود ندارد. البته همین حالا هم قوانینی برای مقابله با تهدید و باجگیری وجود دارد، اما برای مشخصتر کردن مقررات برای جلوگیری از موارد اینچنینی، برخی کشورها به دنبال روشهایی هستند که بتوان بهواسطهی آن، نوعی کپیرایت را برای افراد در نظر گرفت که نتوان از چهرهی افراد برای هر منظوری استفاده کرد.

نظر کاربران

خوراک ایرانیانست...

پاسخ ها

برخور دهای فیزیکی و قهری و اجبار به قبول باورهای ناپایدار ، جواب نداده و نمی دهد ، از دو فاز کردن جامعه و ارزشها ، کسی سود نمی برد حتی شما که کارهای فرهنگی این نسل را اداره کرده اید .

برترین ها چند تا فوتوشاپ خوب معرفی کن